선형대수 | 해석학 | 통계학

[Bayesian Deep Learning] 베이지안 딥러닝, Bayesian deep neural network

[용어 정리] Variational Inference (변분 추론): 변분 추론은 확률 분포를 근사화하기 위한 효율적인 방법입니다. 주어진 데이터와 모델의 파라미터 사이의 관계를 활용하여 모델의 파라미터를 추정하고, 이를 통해 원하는 확률 분포를 근사합니다. 변분 추론은 빅데이터 및 복잡한 모델을 다룰 때 특히 유용합니다. 예를 들어, 가우시안 혼합 모델을 고려해 봅시다. 우리는 관측 데이터 ( X = {x_1, x_2, ..., x_N} ) 가 있고, 이 데이터가 가우시안 혼합 모델 ( p(x|\theta) ) 에 따라 생성되었다고 가정합니다. 이 때, 우리의 목적은 데이터를 가장 잘 설명하는 모델 파라미터인 ( \theta ) 를 찾는 것입니다. Log Marginal Likelihood (로그 주변..

[통계학] Transformations and Expectations

Random variable X로 cdf Fx(x)를 모델링한다. 이 X의 함수로 distribution of Y=g(x)를 구해보자. ex) X={1,2,3,4,5,6}이고 Y=g(x)=2X라고 하면 Y={2,4,6,8,10}이다. g(.)는 monotone increasing이다. ex2) X~Unif(0,2ㅠ), Y=g(x)=sin(X)이라면 X={x:0

[통계학] Probability Theory

S라는 set에서 B는 S의 subsets. P는 every event에 대한 probability, P(A)=A event의 probability. P를 probability distribution이나 probability measure이라 부른다. Axioms of Probability 그리고 을 만족하면 countable additivity 성질을 지닌다. Central limit theorem The central limit theorem (CLT) explains the ubiquitous occurrence of the normal distribution in nature, and this theorem, according to David Williams, "is one of the great..

[선형대수/머신러닝] 머신러닝에 기초인 선형대수 정리

머신러닝이 가장 기본적인 원리의 기초가 되는 선형대수 부분을 정리해보았다. 왜 머신러닝을 하면 수학, 특히 선형대수를 공부하라고 할까? 머신러닝은 가설 Wx+b와 실제 y를 반복적인 훈련(epochs)으로 가깝게 만드는 것(=최적화) 그 가장 기초가 되는 수학은 y = Wx+b 함수의 기울기 W와 bias b로 계산된다. linear한 함수를 regression 즉, 선형회귀. 참고: 동빈나 유투브 https://www.youtube.com/watch?v=ve6gtpZV83E

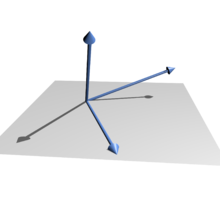

[선형대수/Linear Algebra] 선형독립 vs 선형종속

선형독립 Linearly Independent vs 선형종속 Linearly Dependent 위키백과에 따르면 In the theory of vector spaces, a set of vectors is said to be linearly dependent if at least one of the vectors in the set can be defined as a linear combination of the others if no vector in the set can be written in this way, then the vectors are said to be linearly independent.

[선형대수/Linear Algebra] Rank(계수) 개념 정리

위키백과에 따르면, Rank의 정의는 이렇습니다. In linear algebra, the rank of a matrix A is the dimension of the vector space generated (or spanned) by its columns. 행렬 A의 랭크는, A의 열로 생성 또는 span된 벡터공간의 차원이다. 행공간과 열공간의 차원은 같으므로 이는 랭크의 개념에도 접목됩니다. 행렬에 가우스소거법을 적용하여, 사다리꼴 행렬에서 0이 아닌 행의 개수가 rank라고 계산해 된다. (이때도 물론 행 랭크와 열 랭크 같음)